Frontières entre l’Homme et la technologie

Étant donné toutes ces technologies, quelle est votre vision de notre vie quotidienne d’ici dix ans ?

Je pense que nous en reviendrons à ce que nous avions envisagé dès le début des années 1990, quand l’informatique ubiquitaire est apparue pour la première fois dans des endroits comme le Xerox PARC à Palo Alto, avec des chercheurs comme Mark Weiser et les tous précurseurs en la matière. Ils portaient l’idée que l’infrastructure informatique se généraliserait et, presque selon un principe socialiste, que nous partagerions cette infrastructure. À cette époque, il n’y avait pas de téléphones portables et les écrans étaient des choses précieuses, généralement couplés à un ordinateur donné. Je pense que nous allons vers une époque où le monde de l’information sera une plaque tournante passant continuellement du wearable à l’infrastructure. L’information nous atteindra de différentes manières : elle nous sera projetée directement dans les yeux et les oreilles ou sera issue d’écrans et d’enceintes. Dans ce monde, des flux montants de données issus de capteurs placés un peu partout et des flux descendants d’informations contextuelles viendront nous guider dans ce que nous faisons, mais aussi guider les choses « numériques » à proximité. Ce n’est pas comme si nous sortions un téléphone : je pense qu’il y aura très peu de choses de

ce type, où il faudra exécuter une application et faire des choses

qui détournent notre attention. Le monde n’est pas une app,

et, dans le cadre d’une informatique ubiquitaire, les utilisateurs ajouteront des capacités en connexion permanente au lieu de télécharger des programmes.

Il s’agira simplement de nous-mêmes, centrés sur ce que nous faisons : le numérique se manifestera de la bonne manière autour de nous, et nous vivrons environnés par cette infrastructure mutualisée. D’une certaine manière, le rêve des premiers chercheurs en informatique ubiquitaire sera devenu réalité. Et oui, l’apprentissage automatique fait d’immenses progrès : nous n’en percevons actuellement que les prémices. Le contexte a toujours été quelque chose de difficile parce que le monde réel est saturé de bruit. Prendre une décision fiable sur ce que nous devons faire est donc difficile. Les choses se sont cependant améliorées, car nous disposons de nouvelles informations : il y a tout simplement davantage de données. Et nous arrivons de mieux en mieux à apprendre des algorithmes, à utiliser l’apprentissage profond, le deep learning, par des approches connexes et des équipements qui sont optimisés pour ce genre de chose. Cela sera mis à contribution de manière beaucoup plus prononcée. Nous ne continuerons pas longtemps à toucher des écrans du doigt.

Comment cela impactera-t-il la façon dont nous concevons les maisons, les bureaux, etc. ?

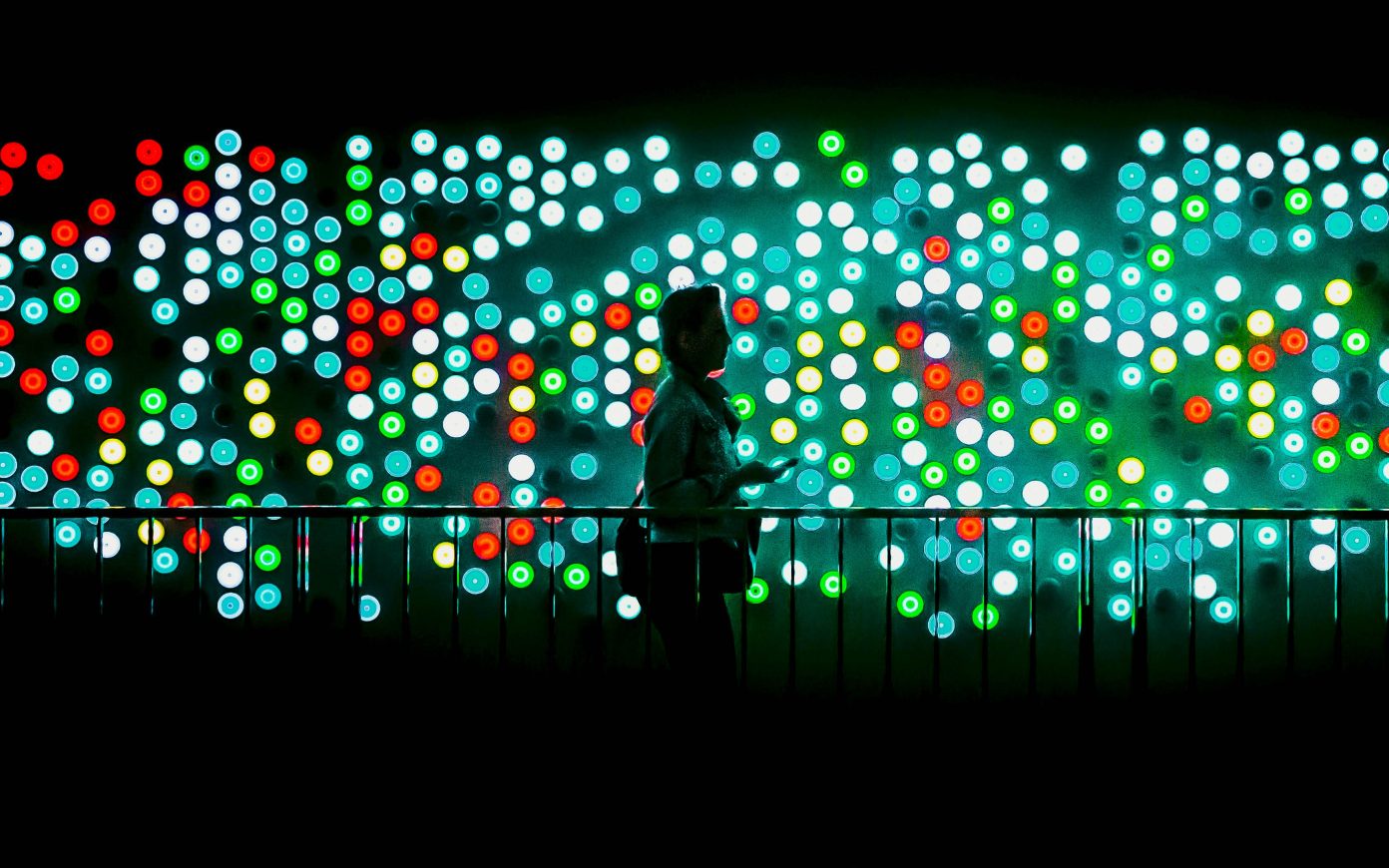

C’est une excellente question. Je ne suis pas architecte, mais je soupçonne que la dichotomie publique/privé est déjà en train de changer. Prenez un bureau moderne par exemple : il est en grande partie ouvert, avec des personnes qui travaillent dans des environnements ouverts. Je pense que les individus souhaitent naturellement pouvoir travailler également dans des environnements privatifs. Nous avons une tension entre ces deux pôles. Cela dépend de ce que fait l’équipe et de la dynamique en place. Mais je pense qu’il y aura différentes façons de s’isoler au sein d’un environnement public – les dispositifs de type wearable en sont un exemple. Il y aura aussi une révolution dans la façon dont nous nous connecterons aux autres dans des environnements publics et privés : d’autres personnes pourront être virtuellement en notre présence de beaucoup de manières différentes, et pas seulement par vidéoconférence. Je suspecte qu’à terme ce type d’infrastructure changera la nature de l’espace perçu : il y aura des affichages publics, des transferts de tous types d’informations, aussi bien personnelles qu’esthétiques, en lien avec l’espace. L’éclairage sera complètement dynamique : tout sera mis en réseau.

Imaginez un bâtiment au sein duquel vous disposez d’un ordinateur wearable. À quoi cela ressemblera-t-il ? C’est une idée intrigante. Certaines personnes ont exploré cette question au travers de la science-fiction et des romans de fantasy, mais nous n’en sommes désormais plus très loin. Nous bidouillons actuellement un HoloLens de chez Microsoft, avec tout un paysage extérieur qui se peut se manifester sur une simple table. Quand on le porte, on est immédiatement projeté dans un splendide paysage où l’on peut circuler virtuellement, voir des informations de capteurs se manifester, pointer vers eux et interagir avec. Cela a longtemps été du domaine de l’imaginaire, mais nous sommes désormais en train de le construire. Les rôles du virtuel et du réel vont changer. Ces constructions seront mobiles, et nous porterons notre bulle virtuelle avec nous lorsque nous nous déplacerons. La définition future de l’individu est tout aussi fascinante. Quoi qu’il en soit, cela affectera probablement les espaces de travail mais aussi les espaces sociaux. Je ne sais pas exactement comment se passera le déploiement, mais des architectes très créatifs y prendront part ; ils pourront aller très loin avec cela, j’en suis certain.