Quelles sont les spécificités de l’intelligence artificielle dite « organique » que vous développez et en quoi se distingue-t-elle des IA qualifiées de « faibles » que nous connaissons aujourd’hui ?

Ce que tout le monde appelle intelligence artificielle aujourd’hui n’a rien à voir avec l’intelligence. Il s’agit en réalité de deep learning ou de machine learning : une manière d’apprendre basée sur des exemples. En donnant des millions d’exemples à une machine et en lui apprenant de quoi il s’agit, elle devient capable de les reconnaître. Le duo entre ce qui est montré et ce qui doit y être associé est indispensable. Cette association entre l’image et le concept qu’elle représente est appelée l’« annotation ». À partir de là, la machine va être capable d’établir une sorte de crible lui permettant d’identifier une nouvelle information. Par exemple, pour reconnaître une tumeur sur une radio des poumons, il faudra d’abord soumettre des millions de radios à la machine, en lui indiquant s’il s’agit d’images avec ou sans tumeur, si elles sont bénignes, malignes, de stade 1, 2 ou 3. Grâce à cette catégorisation établie par l’homme, la machine va ensuite procéder par analogie et discrimination, devenant capable de catégoriser un nouvel exemple jamais rencontré.

C’est en cela que consiste ce que l’on appelle « intelligence artificielle » aujourd’hui, mais il ne s’agit que de statistiques et de puissance de calcul, nullement d’intelligence. C’est la raison pour laquelle je préfère parler d’IA plutôt que d’intelligence artificielle, pour éviter d’avoir à prononcer le terme. Les limites de cette technologie sont d’ailleurs évidentes, car il suffit de chercher à identifier une chose qui n’a encore jamais été catégorisée pour que le système s’enraye. Si vous montrez une image de pangolin à une machine sans lui avoir appris au préalable à en reconnaître un, elle sera incapable de le caractériser. C’est le problème qui se pose avec la conduite autonome. Il est impossible d’établir une liste exhaustive des situations dans lesquelles une voiture pourrait se trouver. Impossible donc de rendre quasi nul le risque d’accident. Conceptuellement, il n’y a pas de place pour la surprise dans le système de prévision. Ces IA dites faibles, si elles ne sont pas douées d’adaptabilité, sont tout de même extrêmement précieuses dans certains domaines. En radiologie elles sont par exemple capables d’élaborer de meilleures réponses que l’être humain et vont, de ce fait, prendre de plus en plus de place dans une société où les exigences de résultat vont croissant.

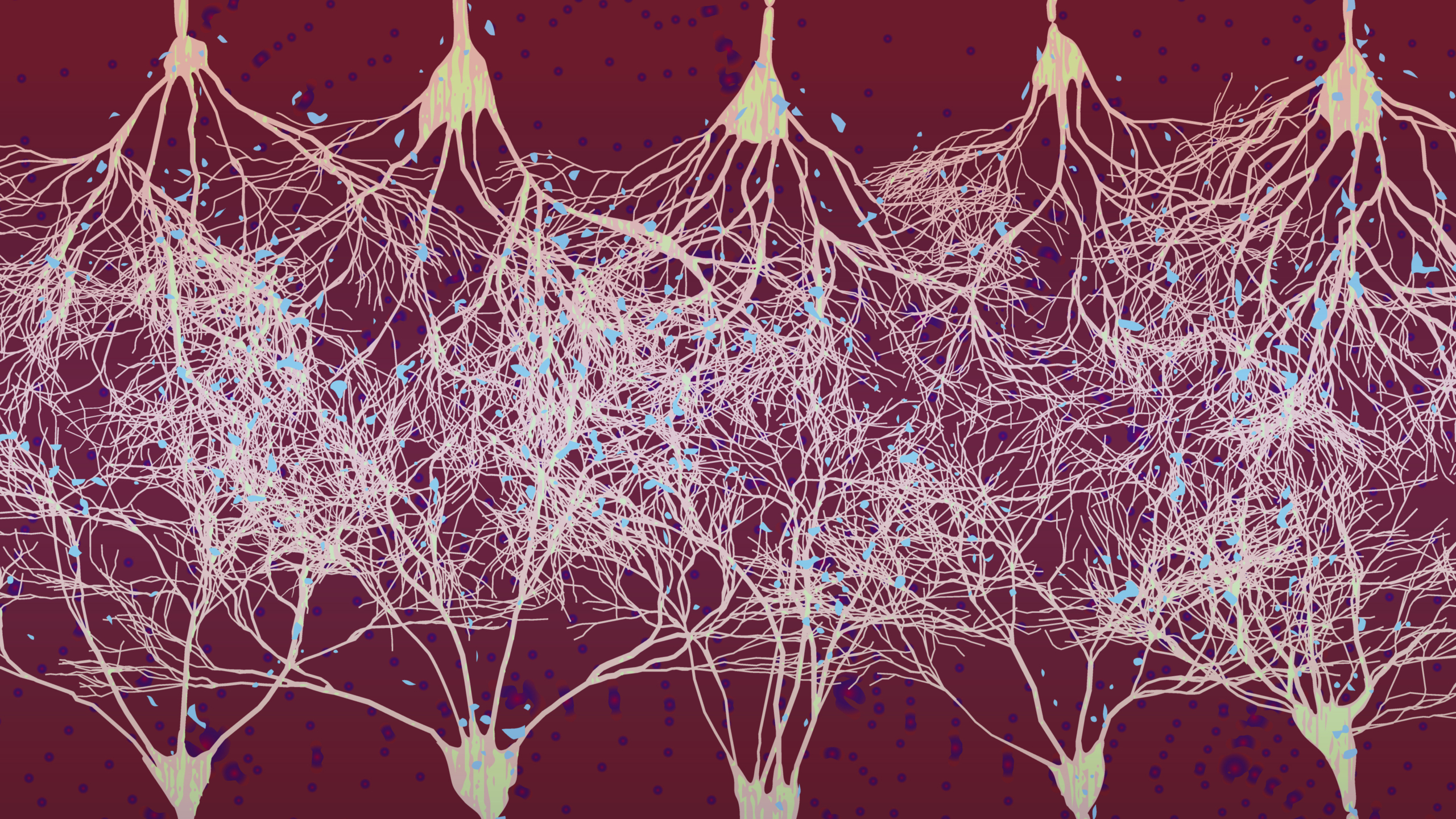

Le cerveau fonctionne différemment. Il n’a pas besoin de milliards d’exemples pour comprendre. Deux essais suffisent. Un enfant que l’on emmène dans un musée d’art moderne reconnaîtra instantanément une chaise et sa fonction, même si elle présente une forme et des couleurs inédites. Le cerveau analyse des situations extrêmement pragmatiques et basiques, puis examine la structure avant d’établir une hiérarchie et de reconstruire un schéma à partir de ce qu’il a déjà vu. C’est ce fonctionnement que je cherche à reproduire. Le but d’AnotherBrain est de reconstituer un petit cerveau, un circuit intégré qui aurait une « vraie » intelligence. En nous inspirant du fonctionnement cérébral, nous cherchons à développer une IA que nous appelons « organique ».

La première similitude est qu’elle consomme très peu d’énergie, comme le cortex cérébral. Notre cerveau n’a besoin que de 20 watts pour élaborer toutes ses fonctions, et la partie dite « cognitive », responsable de l’intelligence, ne consomme que 5 watts, moins que la plus petite des ampoules de votre plafond ! Or le deep learning consomme 500 kW simplement pour mettre au point un crible, avec une émission carbone équivalent à celle de cinq voitures durant toute leur durée vie. Le coût est énorme si on le rapporte à la société entière. Évidemment, si l’on compare les avantages et les inconvénients, cela peut se justifier, mais il faut garder à l’esprit l’ampleur de cette empreinte carbone.

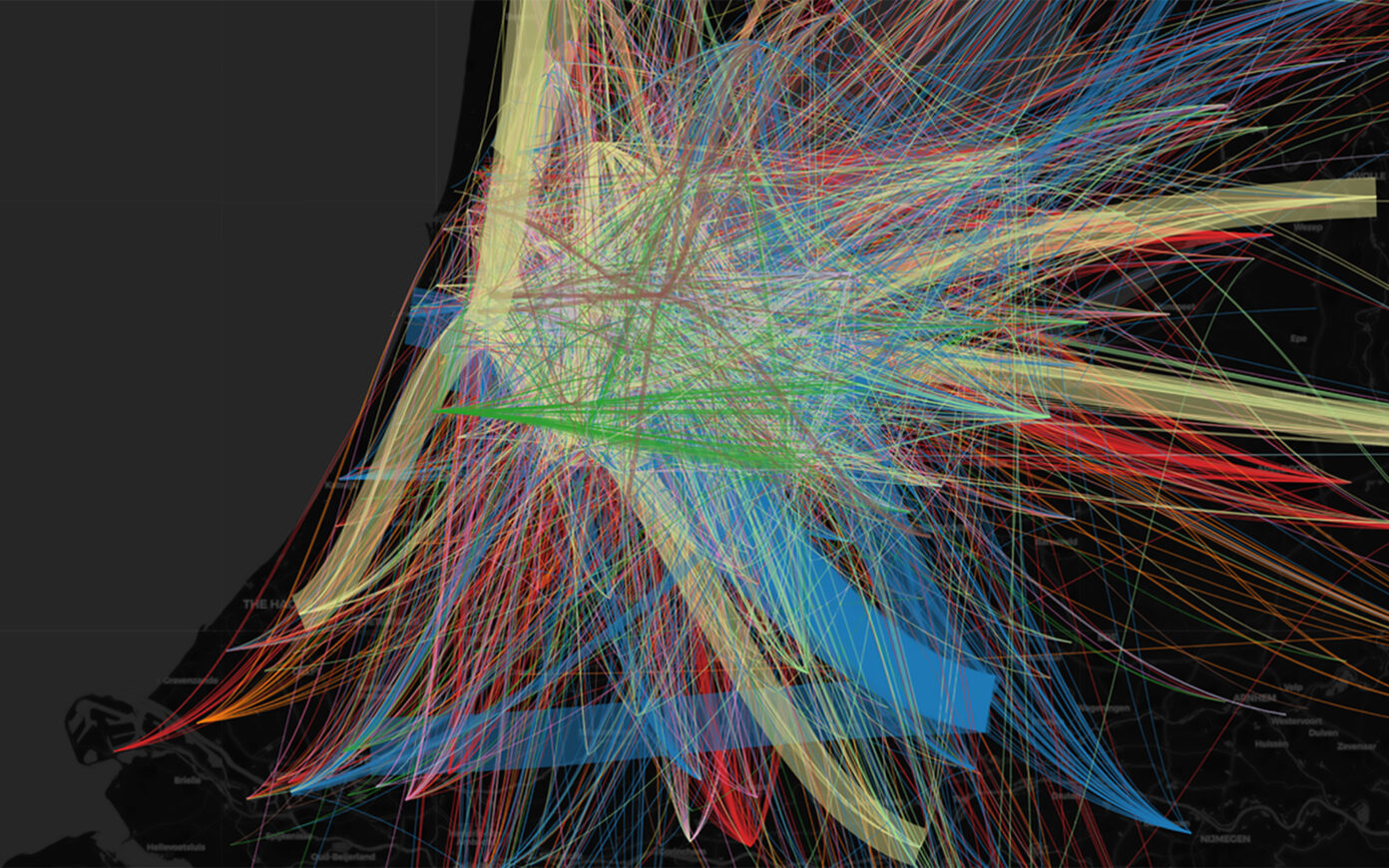

Nous cherchons par ailleurs à contourner les limites de l’IA mainstream au niveau des données. Tout comme le cerveau, l’IA organique ne fonctionne pas à partir d’une situation déjà prédéfinie, mais est capable d’analyser et de comprendre une situation rencontrée pour la première fois, ce qui est très utile pour faire face à des situations où les données ne peuvent être catégorisées et annotées, comme dans le cas de la voiture autonome. Et c’est particulièrement intéressant dans les situations où les données manquent. Par exemple, dans le cas des observatoires qui cherchent à détecter des planètes extrasolaires, c’est-à-dire qui tournent autour d’autres étoiles et non pas du soleil, la reconnaissance est permise par la détection de l’impact de ces planètes sur le rayonnement de leurs étoiles. Dans ce cas, l’IA serait très utile, mais avec les outils que nous possédons aujourd’hui, le deep learning donc, il serait nécessaire d’établir un crible à partir de données de luminosité d’un grand nombre d’étoiles et d’annoter la présence d’une ou plusieurs planètes autour, données que nous n’avons pas puisque c’est précisément ce que nous recherchons. Dans l’immense majorité des cas, il nous est donc encore impossible d’appliquer une IA performante et nous continuons à utiliser des outils traditionnels : manuels dans le cas de la voiture, lunettes optiques ou astronomiques dans celui de la recherche de planètes.

Enfin, la technologie que nous développons cherche à résoudre un des grands problèmes auquel l’IA fait face : celui de l’explicabilité. Aujourd’hui, aucune IA faible n’est capable d’analyser la constitution de son verdict. Elle est capable de dire « oui » ou « non », « chat » ou « chien », « malade » ou « sain » grâce à l’analyse de millions de données, mais il lui est impossible de démontrer pourquoi. Cette absence de justification est inacceptable. Prenez l’exemple des banques, qui pourraient utiliser l’IA pour accorder des crédits. Grâce à l’historique de millions de clients, à l’état de leurs comptes et à leurs expériences de crédits passées, elles seraient capables d’établir des catégories de profils types – « remboursera », « ne remboursera pas » – pour répondre à de nouvelles demandes. C’est extrêmement important parce qu’aujourd’hui le crédit repose sur des critères tangibles et mesurables comme le salaire, l’âge, le coût du loyer, le type d’emploi, etc. Son octroiement ne dépend que de la capacité du contractant à rembourser de manière autonome et au temps présent. Or, la vie est bien plus complexe qu’un compte en banque. Il existe des gens qui, par principe, rembourseront toujours leurs dettes, à l’aide de leurs proches peut-être, et d’autres qui chercheront volontairement à frauder. La réalité n’est pas simplement liée au fait qu’un individu ait la capacité ou non de rembourser un crédit. Elle est étroitement liée à des facteurs culturels et individuels. Les banques vont donc progressivement compléter leurs données bancaires avec des données afférentes au comportement et à la vie courante, ce qui va soulever en parallèle des questions de privacité de l’information.

Quoi qu’il en soit, une fois que le système est enrichi et que le profil « ne remboursera pas » est établi de manière fiable, comment justifier le refus de crédit ? Est-ce parce que l’individu est une femme, qu’il est de couleur, qu’il est célibataire avec deux enfants à charge ? Est-ce de la discrimination et comment justifier qu’il ne s’agit pas de cela ? Un simple « non », sans explication de la raison, n’est pas acceptable. C’est un des problèmes des IA classiques. Or notre système, puisqu’il construit une réponse en comprenant une situation, devient capable d’en justifier la raison. L’intelligence artificielle que nous cherchons à mettre au point est donc une véritable intelligence « organique », puisqu’elle consomme peu d’énergie, n’a pas besoin d’une grande quantité de données pour élaborer une réponse et produit des résultats explicables.

Comment est-il possible d’apprendre à une IA à analyser une situation ? Votre équipe transdisciplinaire étant notamment composée de neurobiologistes, vous inspirez-vous du processus d’apprentissage du cerveau ?

Je prendrais plutôt l’exemple des insectes sociaux : les abeilles, les fourmis ou les termites. Les termites sont des animaux primitifs et relativement peu « intelligents ». Pourtant, en s’associant, ils sont capables de construire des architectures de cinq à dix mètres de haut, avec un contrôle différencié de la température, de l’humidité et de la vitesse de circulation de l’air selon qu’il s’agit de pièces où sont élevés des œufs ou des champignons. Même s’il fait quarante degrés à l’extérieur, il ne fait jamais plus de vingt-huit degrés dans une termitière, et cela sans consommer la moindre énergie. Mais le plus magique est de constater que lorsque l’on déplace des termites, elles reconstruisent une termitière dotée des mêmes fonctions avec, probablement, une forme différente. On observe donc à la fois une réitération et une variation. Les termites ne suivent pourtant pas un ordre social organisé avec des « chefs de chantier » et des « ouvriers », des « dirigeants » et des « exécutants ». Ces animaux sont très peu doués de communication et ne sont soumis à aucun principe de contrôle ou de supervision. On peut alors se demander comment un individu si peu évolué d’un point de vue biologique peut donner un collectif si intelligent. C’est ce que l’on appelle le principe d’émergence.

En donnant quelques règles élémentaires à un « agent », puis en associant plusieurs « agents » ensemble, il y a des comportements qui émergent, un phénomène global qui apparaît. Cette nouvelle capacité est une caractéristique propre à la synergie, dont les « agents », pris isolément, sont dépourvus. C’est la base du fonctionnement des systèmes complexes, celui qui permet aux neurones de donner un cerveau ou à une cellule de donner un corps.

S’il a été observé, le phénomène d’émergence reste extrêmement théorique car personne n’a encore percé cette loi naturelle, ni décrypté ses règles. Nous n’en connaissons donc pas le mécanisme, seulement le principe. Nous savons cependant que chaque « agent » possède quelques règles élémentaires lui permettant de réaliser une vingtaine d’actions différentes. Il suffit alors de trouver les bonnes règles de base à chaque « mission ». Prenons la « mission » fourmilière, puisqu’il s’agit d’un célèbre challenge dans le monde de l’informatique. Le record pour construire une fourmilière virtuelle a été atteint avec seulement trois règles de base :

- Lorsque la fourmi rencontre une boulette de terre imbibée d’un taux de phéromones compris entre deux seuils, elle la saisit et l’empile sur une autre.

- Lorsque la hauteur du tas dépasse celle de la fourmi debout, la boulette est juxtaposée latéralement à celle du dessus de la pile pour fermer un couloir

- Lorsque le taux d’humidité est supérieur à un certain seuil, la boulette est juxtaposée latéralement à une autre

Ces règles sont suffisantes pour adapter l’architecture au contexte. Puisque la ventilation de l’air modifie les taux de phéromones, c’est en fonction de celle-ci qu’est définie la forme des pièces et, lorsque l’humidité augmente, les piliers de la fourmilière sont épaissis pour éviter son effondrement. C’est d’une extrême simplicité.

Notre intelligence artificielle organique fonctionne comme une fourmilière, selon la logique d’un système multi-agent. Avec un minimum de règles simples, elle est capable d’élaborer une tâche complexe. Cela nous permet de contourner le problème auquel l’IA classique fait face, par exemple dans le cas de la conduite autonome. La voiture est capable de reconnaître une moto, non parce qu’elle aura vu sa photo, mais parce qu’elle aura intégré des règles de bases lui permettant de l’identifier : deux roues épaisses, un bruit, un personnage ou deux assis dessus, une bille brillante au niveau de la tête (le casque) etc. Peu importe qu’il s’agisse d’une Harley Davidson ou d’une Triumph, c’est une moto parce qu’elle possède les caractéristiques invariables d’une moto. Il suffit donc de montrer quelques dizaines de situations pour que l’intelligence artificielle soit capable de définir ces invariants de manière totalement autonome. C’est la raison pour laquelle nous avons besoin de si peu de données.

Je pense sincèrement que l’intelligence n’existe pas. De la même manière qu’une termitière est édifiée « comme si » les termites étaient des architectes, des ingénieurs, des chefs de projet, un cerveau fonctionne « comme si » il était intelligent. Il ne s’agit, en réalité, que d’un certain nombre de mécanismes mis bout à bout qui, vus de l’extérieur, donnent une impression d’intelligence. Les colonnes corticales (des associations tubulaires de cent dix neurones), à l’image des termites, sont les éléments de base du cortex. Ces petits tubes de neurones sont tous strictement identiques, mais selon qu’ils se branchent au nerf optique ou au nerf auditif, ils traitent du son ou de la lumière. Puisqu’il s’agit strictement des mêmes colonnes, cela signifie que le cerveau traite de la même manière tout ce qui est auditif, visuel, tactile, tout ce qui est de l’ordre de l’action et de l’intelligence, de la stratégie, de la cognition…

Cette intelligence organique capable d’apprentissage autonome est néanmoins dépourvue d’une valeur fondamentale du vivant : la conscience de soi, qui oriente la prise de décision, notamment dans les situations critiques. Parviendra-t-on à obtenir de véritables IA sans conscience de soi ? Et qu’en est-il de l’imprévu, qui a une part si importante dans la nature ?

Ce point soulève une question profonde, celle de la croyance. Soit vous concevez le cerveau comme un organe purement biochimique, et à ce moment-là il est reproductible. Soit vous croyez qu’il existe une âme, et à ce moment-là les machines n’en seront jamais pourvues. À la question « y aura-t-il toujours une différence entre les réalisations de la technologie et un cerveau humain ? », ma réponse est : « Ça dépend de si vous croyez en Dieu »…

J’ai beaucoup travaillé sur les émotions au travers de la robotique. Les émotions jouent un rôle précieux dans la survie de l’individu. La peur engendre la sécrétion d’adrénaline, atténue la douleur, accélère les réactions, c’est un processus de défense très efficace. L’amour suscite l’envie de procréer et d’engendrer une descendance. La chimie est à l’origine de ces changements de comportements brutaux, qui représentent généralement un coût important pour l’organisme, raison pour laquelle ils n’adviennent que ponctuellement, au bon moment.

Si un jour les robots deviennent suffisamment sophistiqués et évolués, s’ils acquièrent une utilité réelle dans nos vies quotidiennes, n’aura-t-on pas envie qu’ils soient capables d’assurer leur propre défense ? Si un robot assure des fonctions vitales d’assistance à des personnes âgées, s’il prend soin d’eux, les nourrit, les lave, évidemment que nous allons le doter de la peur du feu et de l’amour de la personne dont il a la charge. Il s’agit d’aller bien au-delà du mimétisme des sentiments, qui fait apparaître un sourire factice sur un visage de machine. Il s’agit de doter les robots de réelles émotions, de vrais sentiments. Nous saurons faire cela, inéluctablement.

Tout comme je ne crois pas qu’il existe d’intelligence, je ne crois pas au « hasard ». Je pense que tout mécanisme élémentaire est explicable, même si on ne sait pas encore le faire. En surmontant la complexité statistique d’accumulation d’énormément de valeurs, il devient possible d’expliquer et d’analyser un phénomène dans sa globalité. Ce que vous appelez l’imprévu peut donc être anticipé. Rien ne dit à la naissance que tel individu se mettra à fumer. Pourtant l’analyse de sa personnalité, de sa relation à ses amis, de sa sensibilité aux influences, le comportement de ses parents, les films qu’il aura vus, valorisant ou dévalorisant cette pratique… permettra statistiquement de prévoir son comportement.

Il n’y a rien que la nature sache faire que nous ne serions capables de reproduire, du moment que l’on accepte que le monde pourrait fonctionner sans un Dieu. Nous sommes en effet assez proches du moment où nous saurons recréer un cerveau fonctionnant exactement comme dans la nature.

Nous sommes actuellement confrontés à une forte défiance de l’opinion publique face aux nouvelles technologies, qui relève d’un sentiment de peur et de perte de contrôle. Que peut-on imaginer de positif et de rassurant sur les débouchés d’une IA encore plus élaborée ?

La peur est en effet une réaction normale, naturelle, qui accompagne le déploiement de toute nouvelle invention significative. Dans le cas de la machine à vapeur, par exemple, Lavoisier, un des plus grands chimistes du XVIIIe siècle, avait calculé que l’entrée de la locomotive et de ses wagons dans un tunnel écraserait, par effet de surpression, la cage thoracique des hommes. Avant lui, d’autres scientifiques soutenaient que le corps humain n’était pas capable de supporter une vitesse supérieure à celle d’un cheval au galop. Chaque fois qu’une nouvelle invention fait son apparition, elle génère de la crainte en ouvrant des possibilités qui n’avaient pas été imaginées. La première réaction naturelle est donc la peur, puis le rejet, avant finalement de commencer à s’approprier le sujet.

Toute nouvelle technique ou technologie comporte des risques importants à ses débuts, mais l’humanité a toujours su progressivement les encadrer pour en tirer plus de bénéfice que de maléfice. Ce sont les accidents qui ont permis, et permettent encore, d’élaborer le système de contrôles, lois, codes, assurances et autres règlements éthiques améliorant l’usage d’une nouvelle technologie au cours du temps.

À l’invention de l’électricité, il y eut énormément de catastrophes. Cette chose invisible et impalpable, d’une puissance phénoménale, a fait brutalement son entrée alors que nous vivions dans un monde d’artisanat relativement maîtrisable. Mais avec le recul, on peut dire que l’humanité en a globalement tiré plus de bien que de mal. Dans le cas du nucléaire, nous n’avons pas acquis assez de recul et craignons encore des guerres atomiques ou des catastrophes comme celle de Tchernobyl ou de Fukushima. Mais c’est sans compter le nombre de cancers qui sont traités chaque jour par irradiation. Si notre priorité est de traiter le problème de très long terme, on peut essayer de trouver une autre forme d’énergie. Mais s’il s’agit d’enrayer la destruction de l’environnement et de la planète à court terme, nous avons tout intérêt à miser sur le nucléaire. Des solutions encore plus écologiques viendront dans un second temps. C’est ce qui se profile avec la recherche sur la fusion nucléaire, une technologie d’une tout autre nature, qui permettra à l’humanité de produire de l’énergie propre, gratuitement et en quantité colossale. De ce point de vue, la fusion nucléaire est le véritable sujet du futur.

Avec les robots, l’IA, ou l’internet généralisé, il se passe la même chose. L’humanité n’a pas encore eu le temps d’établir un cadre pour diminuer les risques et maximiser le positif. Cela passera inévitablement par une phase d’accidents, où des personnes mal intentionnées chercheront à tirer parti de ces technologies. Avec les voitures autonomes, nous faisons déjà face à des cas de hacking. Quelqu’un peut prendre le contrôle d’une voiture alors qu’elle roule à 150 km/h sur l’autoroute et menacer de couper le frein si le conducteur ne lui verse pas d’argent. Alors est-ce qu’il y a des risques ? Oui, il y en a. Est-ce que nous allons assister à des catastrophes ? Oui, il y aura des problèmes. Est-ce que globalement, pour le bien de l’humanité, il faut arrêter la recherche sur l’intelligence artificielle ? Surtout pas ! Elle annonce de véritables progrès pour nos sociétés.

Mon seul objectif est d’améliorer la vie des gens. Je rêve de développer une intelligence artificielle offrant à chacun un Jiminy Cricket, son petit majordome personnel. Une intelligence artificielle qui connaisse si bien son propriétaire qu’elle serait capable d’évaluer ses besoins en temps réel et d’y répondre de la meilleure des manières, comme une sorte de cerveau annexe. Le monde va devenir de plus en plus complexe, et l’intelligence artificielle va nous permettre d’y faire face, sans quoi nous serons totalement perdus. De nombreux métiers ne seront plus effectués par des hommes dans le domaine du droit et de la médecine, par exemple, et à ce titre le revenu universel deviendra une évolution sociétale inévitable. La valeur d’un médecin réside dans la compréhension de la personne qui est en face de lui. La prescription, elle, se déduit ensuite de façon presque algorithmique. Mais combien de questions un médecin peut-il poser à un patient ? Vingt ? Cinquante ? Il lui est impossible de prendre en compte une grande quantité de facteurs. Or, dans un corps, il y a des milliards d’informations qui, données à une machine, lui permettraient d’établir un diagnostic infiniment plus précis que celui de l’homme. Il suffirait d’une petite piqûre pour analyser en parallèle l’ADN, avec le taux d’hormones, le régime alimentaire, les antécédents, etc.

L’étape suivante n’est autre que l’ingénierie génétique. Encore une fois, nous faisons face à une réticence. Pourtant le résultat est déjà recherché par d’autres moyens : dans certaines sociétés on a dans le passé tué les bébés filles en faveur des garçons, dans d’autres les préférences esthétiques conduisent à des opérations de chirurgie extrêmement lourdes et dangereuses. Aujourd’hui, on sait que par fécondation in vitro et analyse génétique, certains sélectionnent les embryons en fonction de critères de sexe, de couleur d’yeux, de taille ou d’intelligence potentielle, etc. Il n’y a pas modification du génome à proprement parler, mais déjà un désir de sélection et de modification de l’aspect. Plutôt que de mutiler, de tuer, il n’est pas insensé d’imaginer agir directement à la racine. Il faut faire attention, parce que les réponses aux questions éthiques ne sont jamais blanches ou noires. Il me semble évident que nous ne renoncerons pas à intervenir pour soigner des maladies génétiques quand la technologie sera au point, et à partir de là il faudra expérimenter de nouveaux cadres, car les tentations transhumanistes se feront plus pressantes. En tout cas c’est aussi en cela que je pense que l’IA et la robotique vont avoir un impact important sur la société, en permettant indirectement à l’ingénierie génétique d’être plus efficace. Mais c’est bien la génétique qui incarnera le plus profond bouleversement de l’humanité à venir, et je suis convaincu que nous serons tous manipulés génétiquement d’ici une vingtaine d’années.